自动交易平台的数据同步机制是保障市场数据高效流动与交易可靠性的核心环节,该机制通过多层级架构实现实时数据采集、清洗与分发,结合容错设计(如冗余服务器、心跳检测)确保异常场景下的服务连续性,关键技术包括低延迟传输协议(如WebSocket)、分布式消息队列(如Kafka)缓解峰值压力,以及基于时间戳或版本号的冲突解决策略,保证跨数据中心的数据一致性,部分平台引入区块链技术强化审计追踪能力,优化方向聚焦于微秒级延迟压缩、动态负载均衡及自适应压缩算法,以平衡吞吐量与资源消耗,该系统的稳健性直接影响交易执行质量与风险控制效能,是量化金融基础设施的关键组成部分。(198字)

数据同步在自动交易中的核心地位

在当今高速发展的金融科技领域,自动交易平台(Automated Trading Platform, ATP)已成为量化交易、高频交易和算法交易的核心工具,而数据同步机制作为自动交易系统的“神经系统”,直接影响交易决策的准确性、执行速度和整体稳定性。

本文将从技术实现、架构设计、数据一致性保障等角度,深入剖析自动交易平台的数据同步机制,帮助开发者、交易员和系统架构师构建更高效、更可靠的交易系统。

数据同步的基本概念与挑战

1 什么是数据同步?

数据同步是指在不同系统、服务或数据库之间保持数据一致性的过程,在自动交易平台中,数据同步主要包括:

- 市场数据同步(如行情数据、订单簿更新)

- 交易指令同步(如订单状态、成交回报)

- 策略参数同步(如策略配置、风控规则)

2 自动交易平台的数据同步挑战

- 低延迟要求:毫秒级甚至微秒级的延迟可能影响交易执行效果。

- 高吞吐量:高频交易场景下,每秒需处理数万笔市场数据更新。

- 数据一致性:避免因数据不同步导致策略误判或重复下单。

- 容错与恢复:网络抖动、服务器宕机时如何快速恢复同步?

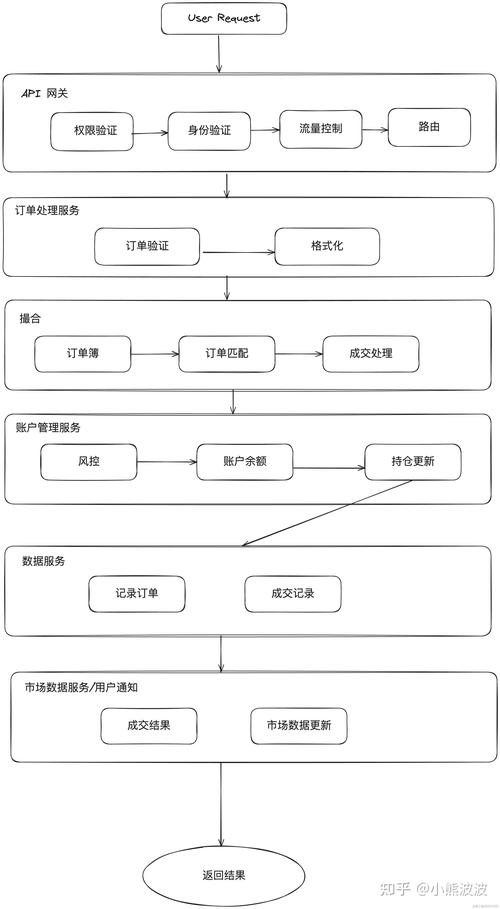

自动交易平台数据同步的典型架构

1 基于消息队列的异步同步

适用场景:高吞吐、低延迟的市场数据分发

代表技术:Kafka、RabbitMQ、ZeroMQ

优势:

- 解耦数据生产者和消费者,提高系统扩展性。

- 支持多订阅者模式,多个策略可并行处理同一数据流。

示例架构:

[交易所API] → [Kafka集群] → [策略引擎1]

→ [策略引擎2]

→ [风控系统]2 基于数据库的增量同步

适用场景:交易记录、账户余额等需要持久化的数据

代表技术:MySQL Binlog、PostgreSQL Logical Decoding

实现方式:

- 通过数据库的日志机制捕获数据变更(CDC, Change Data Capture)。

- 使用Debezium等工具将变更事件推送到消息队列或直接同步到其他数据库。

3 基于内存数据库的实时同步

适用场景:超低延迟的订单簿管理

代表技术:Redis Pub/Sub、Memcached

特点:

- 数据存储在内存中,读写速度极快(微秒级响应)。

- 适用于实时计算买卖价差、订单簿深度等场景。

关键优化技术:如何提升数据同步效率?

1 数据压缩与批处理

- Protocol Buffers (Protobuf) 替代JSON,减少网络传输量。

- Snappy/Zstandard压缩 降低带宽占用,尤其适用于高频行情数据。

2 智能路由与负载均衡

- 使用 Consistent Hashing 确保相同Instrument的数据始终由同一节点处理,减少跨节点同步开销。

- 多数据中心同步:通过 WAN优化技术(如UDP加速)减少跨地域延迟。

3 数据版本控制与冲突解决

- 采用 Vector Clocks 或 Hybrid Logical Clocks (HLC) 标记数据版本,解决分布式系统中的时序问题。

- 在订单状态同步中,使用 乐观锁(Optimistic Concurrency Control) 避免重复成交。

容灾与数据一致性保障

1 故障检测与自动切换

- 心跳检测:通过ZooKeeper/etcd监控节点存活状态。

- 快速故障转移:当主节点宕机时,备用节点在100ms内接管数据流。

2 最终一致性与强一致性权衡

- 最终一致性(Eventual Consistency):适用于行情数据同步,允许短暂延迟。

- 强一致性(Strong Consistency):适用于账户余额、持仓数据,需使用分布式事务(如2PC或Saga模式)。

3 数据回放与断点续传

- 通过 Checkpoint机制 记录同步进度,故障恢复后从断点继续。

- 使用 事件溯源(Event Sourcing) 存储所有数据变更,支持任意时间点的状态重建。

实战案例:某高频交易平台的数据同步方案

1 架构概览

- 数据采集层:直接连接交易所API,使用FPGA加速解码。

- 传输层:Kafka + RDMA网络,确保微秒级延迟。

- 处理层:基于Actor模型的分布式计算框架(如Akka)。

2 性能指标

- 行情数据延迟:从交易所到策略引擎<50μs。

- 订单同步成功率:99.999%(全年故障时间<30秒)。

未来趋势:AI与区块链在数据同步中的应用

1 AI驱动的智能数据路由

- 利用机器学习预测网络拥堵,动态调整数据分发路径。

- 强化学习优化压缩算法,在延迟与带宽间寻找最佳平衡点。

2 区块链保障数据不可篡改性

- 将关键交易数据上链(如私有Hyperledger Fabric),确保审计追踪。

- 智能合约自动校验:在跨机构交易中自动验证数据一致性。

构建健壮数据同步机制的要点总结

- 选择合适的同步模式(Pub/Sub、CDC、内存数据库等)。

- 优化网络与序列化(Protobuf、RDMA、压缩算法)。

- 设计容错机制(心跳检测、Checkpoint、多活部署)。

- 持续监控与调优(延迟、吞吐量、错误率)。

在自动交易的世界里,数据同步不仅是技术问题,更是核心竞争力,希望本文能为你的交易系统设计提供有价值的参考! �

延伸阅读:

- 《Designing Data-Intensive Applications》(Martin Kleppmann)

- 纳斯达克交易所的行情数据分发架构白皮书

- Apache Kafka官方文档中的Exactly-Once语义实现

本文链接:https://www.ncwmj.com/news/1668.html