在寄售系统中,防止卡密重复上传是确保交易安全的关键,系统应设置自动检测机制,通过比对数据库中的已有卡密,实时拦截重复提交的数据,采用唯一性校验技术,如哈希算法或唯一索引,确保每条卡密仅被录入一次,建议引入人工审核流程,结合系统自动筛查,双重保障数据准确性,定期清理无效或过期卡密也能减少重复风险,用户权限管理至关重要,限制操作人员的上传权限,避免人为失误,通过技术手段与流程优化相结合,可有效杜绝卡密重复问题,提升系统可靠性。

在数字商品交易中,寄售系统(Consignment System)是一种常见的交易模式,允许卖家将商品(如游戏点卡、会员卡、充值卡等)托管在平台上,由平台统一管理并销售。卡密(卡号和密码)的重复上传是一个常见的安全隐患,可能导致欺诈、库存混乱甚至法律纠纷。

如何有效限制卡密重复上传?本文将深入探讨几种实用的解决方案,涵盖技术实现、数据库管理和业务逻辑优化,帮助平台运营者提升系统安全性。

为什么卡密重复上传是个大问题?

在寄售系统中,卡密是核心资产,一旦被重复上传,可能会引发以下问题:

- 欺诈风险:同一张卡被多次出售,买家可能无法兑换,损害平台信誉。

- 库存混乱:系统显示库存数量不准确,影响正常交易流程。

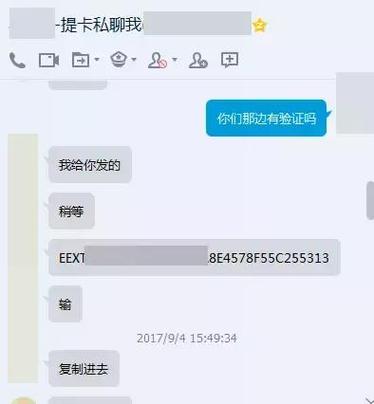

- 法律风险:如果卡密来源不明(如盗刷或黑产),平台可能承担连带责任。

去重机制是寄售系统必不可少的功能。

如何检测和限制卡密重复上传?

(1)数据库唯一索引约束

最直接的方法是在数据库层面设置唯一索引(Unique Index),确保同一卡密只能存储一次。

-- 以MySQL为例,创建卡密表时添加唯一约束

CREATE TABLE card_keys (

id INT AUTO_INCREMENT PRIMARY KEY,

card_number VARCHAR(50) NOT NULL,

card_password VARCHAR(50) NOT NULL,

UNIQUE KEY (card_number, card_password) -- 联合唯一索引

);

优点:

- 数据库自动拦截重复数据,减少代码逻辑复杂度。

- 性能较高,适合大规模数据存储。

缺点:

- 无法灵活处理“部分重复”(如仅卡号相同但密码不同)。

- 错误提示可能不够友好,需前端配合优化。

(2)哈希(Hash)校验

如果卡密较长(如32位兑换码),直接存储原始数据可能占用空间,可以采用哈希算法(如MD5、SHA-256)存储其摘要值,并在上传时比对:

import hashlib

def check_duplicate(card_number, card_password):

# 计算卡密哈希值

card_hash = hashlib.sha256(f"{card_number}{card_password}".encode()).hexdigest()

# 查询数据库是否已存在

if db.query("SELECT * FROM card_keys WHERE hash = ?", card_hash):

return True # 重复

else:

db.insert(card_number, card_password, card_hash)

return False

优点:

- 减少存储空间,提升查询效率。

- 避免明文存储卡密,增强安全性。

缺点:

- 哈希不可逆,无法恢复原始卡密(需权衡安全性与业务需求)。

(3)Redis缓存去重

对于高并发场景,数据库查询可能成为瓶颈,可以利用Redis的SET或Bloom Filter(布隆过滤器)进行快速去重:

import redis

r = redis.Redis()

def is_duplicate(card_key):

if r.sismember("card_keys_set", card_key):

return True

else:

r.sadd("card_keys_set", card_key)

return False

布隆过滤器(Bloom Filter)适合海量数据去重,但可能有误判(需结合数据库二次校验)。

优点:

- 查询速度极快(O(1)时间复杂度)。

- 适合临时缓存或高频检测场景。

缺点:

- 需额外维护缓存一致性(如定期同步数据库)。

(4)业务逻辑限制

除了技术手段,业务规则也能减少重复上传:

- 分批次上传:限制单次上传数量(如每次最多100条),减少人为错误。

- 文件校验:上传前要求用户提供卡密文件,系统自动解析并去重。

- 人工审核:对大额或高风险卡密进行二次确认。

进阶优化:如何提升去重效率?

(1)异步任务处理

如果卡密数量庞大(如数万条),同步检测可能导致超时,可采用消息队列(如RabbitMQ、Kafka)异步处理:

- 用户上传文件 → 系统快速返回“上传成功,正在检测”。

- 后台任务逐条校验卡密,完成后通知用户结果。

(2)分布式去重

在微服务架构下,可使用分布式锁(如Redis RedLock)或唯一ID生成器(如Snowflake)确保跨节点数据一致性。

真实案例:某游戏点卡平台的防重复策略

某知名数字商品交易平台曾因卡密重复导致大量投诉,后采用以下方案:

- 前端拦截:上传前用JavaScript检测重复(减少无效请求)。

- Redis缓存:存储最近7天的卡密哈希,快速比对。

- 数据库唯一索引:最终防线的兜底策略。

- 人工抽查:随机审核10%的上传记录。

实施后,重复卡密投诉下降90%!

限制卡密重复上传的核心思路是:

✅ 数据库唯一索引 → 终极保障

✅ 哈希校验 → 平衡安全与性能

✅ Redis缓存 → 提升响应速度

✅ 业务规则 → 减少人为失误

如果你的寄售系统还未完善去重机制,现在就是最佳优化时机!

你有遇到过卡密重复的问题吗?欢迎在评论区分享你的解决方案! 🚀

本文链接:https://www.ncwmj.com/news/4243.html