在百万级并发场景下,交易系统的稳定性面临五大核心挑战:**资源竞争、数据一致性、系统扩展性、网络延迟及容错能力**,资源竞争需通过分布式锁和异步队列缓解;数据一致性依赖分布式事务或最终一致性方案;横向扩展要求微服务化与动态负载均衡;网络延迟需优化TCP协议与CDN加速;容错则需熔断机制与多级降级策略,应对策略上,建议结合**压力测试(如JMeter模拟)、全链路监控(Prometheus+ELK)及混沌工程(随机故障注入)**,提前暴露瓶颈,高并发系统的核心在于**分层设计(限流-削峰-异步-冗余)**与持续迭代优化,而非单纯追求硬件堆砌。

高并发——交易系统的"生死线"

在金融科技高速发展的今天,交易系统的高并发能力已成为衡量其可靠性的核心指标之一,无论是证券交易、外汇市场,还是电商秒杀、支付清算,系统一旦在高并发场景下崩溃,轻则影响用户体验,重则造成巨额经济损失。

2015年,某知名券商因系统无法承受开盘瞬间的流量洪峰,导致数百万用户无法交易,直接损失超亿元;2020年,某电商平台因"双11"流量激增,支付系统瘫痪30分钟,错失数亿订单,这些案例无不警示我们:高并发测试不是可选项,而是必选项。

如何确保交易系统真正具备高并发能力?本文将从技术架构、测试策略、性能瓶颈、真实案例等维度,深度剖析高并发测试的核心挑战与解决方案。

什么是真正的高并发?——从概念到量化标准

高并发的定义

高并发(High Concurrency)指系统在单位时间内(通常为秒级)能同时处理的请求量,在交易系统中,这一指标直接影响用户体验和业务连续性。

金融级交易系统的并发标准

- 证券交易系统:开盘/收盘瞬间TPS(每秒交易数)需达到10万+

- 支付系统:大促期间需支持50万+ TPS

- 外汇交易系统:毫秒级延迟,并发量需稳定在百万级

高并发与高可用的关系

高并发≠高可用,但二者紧密相关,系统可能在低并发时表现稳定,但在流量激增时因资源竞争、锁冲突等问题崩溃。高并发测试必须模拟真实业务场景,而非单纯堆砌请求量。

高并发测试的五大核心挑战

挑战1:如何模拟真实流量?——从"假负载"到"真场景"

许多团队使用JMeter、LoadRunner等工具模拟请求,但忽略了真实用户的行为随机性(如登录、查询、下单的混合操作)。

解决方案:

- 采用流量录制回放(如TCPCopy、GoReplay)

- 结合用户画像,模拟不同交易策略(高频交易、长线持仓等)

挑战2:数据库成为瓶颈——"慢查询"如何摧毁系统?

在高并发下,数据库的锁竞争、索引失效、连接池耗尽等问题会被放大。

案例:

某期货交易系统在模拟10万并发时,因未优化SQL查询,导致数据库CPU飙升至100%,最终超时崩溃。

解决方案:

- 分库分表(如ShardingSphere)

- 引入缓存(Redis集群化)

- 优化事务隔离级别(避免不必要的串行化)

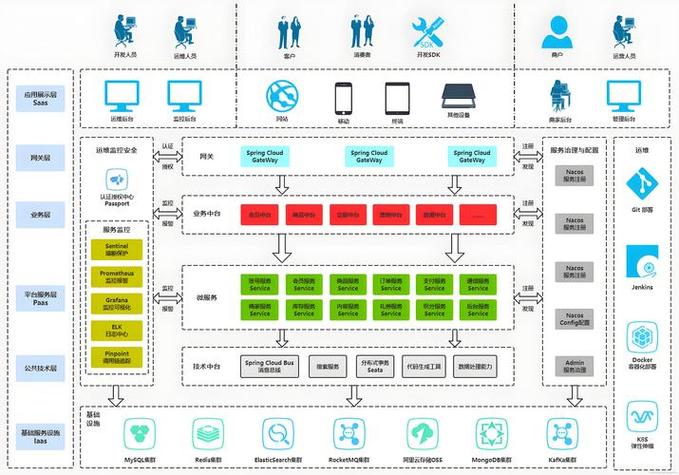

挑战3:分布式系统的"幽灵问题"——一致性、幂等性与雪崩效应

在微服务架构下,高并发可能引发:

- 重复下单(幂等性缺失)

- 资金扣减不一致(分布式事务问题)

- 服务雪崩(某个微服务崩溃引发连锁反应)

解决方案:

- 幂等设计(唯一ID+状态机)

- 限流降级(Sentinel、Hystrix)

- 分布式事务(TCC、SAGA模式)

挑战4:网络延迟——"最后一毫秒"的致命影响

在量化交易中,1毫秒的延迟可能导致套利机会消失。

优化方向:

- 低延迟网络(FPGA加速、RDMA协议)

- 就近部署(边缘计算节点)

挑战5:测试环境与生产环境的差距——"实验室数据"为何不靠谱?

测试环境通常无法完全复现生产环境的硬件配置、网络拓扑和数据规模。

解决方案:

- 影子测试(Shadow Testing):将生产流量复制到测试环境

- 混沌工程:主动注入网络延迟、节点故障等异常

高并发测试的实战方法论

测试阶段划分

- 基准测试:单接口极限性能

- 负载测试:逐步增加压力,观察拐点

- 压力测试:长时间高负载,检测内存泄漏

- 稳定性测试:7×24小时运行,确保无累积性故障

关键指标监控

| 指标 | 健康阈值 | 工具示例 |

|---|---|---|

| TPS | ≥业务峰值需求的120% | Prometheus |

| 平均响应时间 | <100ms(金融级要求) | Grafana |

| 错误率 | <0.01% | ELK日志分析 |

| CPU利用率 | <70%(避免资源争用) | Zabbix |

自动化与持续测试

- CI/CD集成:每次代码提交后自动触发性能测试

- 异常自动回滚:当TPS下降超过阈值时中止发布

行业案例:顶级机构如何做高并发测试?

案例1:纳斯达克交易所的"极端场景模拟"

- 使用硬件加速器模拟毫秒级订单爆发

- 采用故障注入测试熔断机制

案例2:支付宝"双11"备战策略

- 全链路压测:提前3个月模拟真实流量

- 动态扩容:基于预测流量自动伸缩云资源

未来趋势:AI与云原生时代的并发测试

- AI预测流量:通过历史数据训练模型,预判并发峰值

- Serverless架构:按需分配资源,降低成本

- 量子计算潜力:未来或可实时模拟超大规模并发

高并发能力是设计出来的,不是测出来的

测试只能发现问题,而真正的抗高并发能力取决于系统架构的前瞻性设计,建议团队在早期就采用:

- 事件驱动架构(如Kafka消息队列)

- 无状态设计(便于水平扩展)

- 代码级优化(减少锁竞争、避免全局变量)

在金融领域,系统的崩溃成本远高于预防成本,你的交易系统,真的准备好迎接下一次流量洪峰了吗?

本文链接:https://www.ncwmj.com/news/4341.html