** ,发卡网在高并发场景下常面临性能瓶颈,本文从架构优化与实战经验出发,提出系统性升级方案。**架构层面**建议采用分布式微服务设计,通过负载均衡(如Nginx)分散流量,结合Redis集群缓存热点数据,减少数据库压力;数据库推荐分库分表+读写分离,提升I/O吞吐量。**代码优化**包括异步处理订单(如MQ消息队列)、精简事务粒度,并利用CDN加速静态资源。**运维环节**需强化监控(Prometheus+Granfa)与自动扩缩容(K8s),同时通过压力测试(如JMeter)模拟峰值流量,持续调优,实战案例显示,某平台通过上述改造,QPS从500提升至5000+,稳定性显著增强,关键点在于:平衡性能与成本,避免过度设计,逐步迭代验证。

在当今数字化时代,发卡网(如虚拟商品交易平台、会员卡兑换系统等)的业务量呈指数级增长,尤其是在促销活动、节假日或热门商品上线时,高并发访问压力成为系统稳定性的最大挑战,如果处理不当,轻则导致用户体验下降,重则引发服务器崩溃,造成直接经济损失,如何提升发卡网的高并发处理能力,成为技术团队必须面对的核心问题。

本文将围绕发卡网高并发处理能力升级展开,从架构设计、数据库优化、缓存策略、负载均衡、代码优化等多个维度,提供一套完整的解决方案,并结合实际案例,帮助开发者构建更稳定、更高效的交易系统。

高并发问题的根源分析

在优化之前,我们需要理解发卡网在高并发场景下可能遇到的瓶颈:

-

数据库瓶颈

- 大量用户同时查询库存、下单,导致数据库连接池耗尽。

- 频繁的读写操作导致锁竞争,影响整体性能。

-

服务器资源不足

CPU、内存、带宽等资源被瞬间占满,导致响应延迟或宕机。

-

缓存失效

缓存穿透(大量请求直接打到数据库)、缓存雪崩(缓存集中失效)等问题。

-

网络IO瓶颈

频繁的HTTP请求、WebSocket连接等占用大量带宽。

-

代码逻辑问题

未优化的SQL查询、循环嵌套、同步锁滥用等导致性能下降。

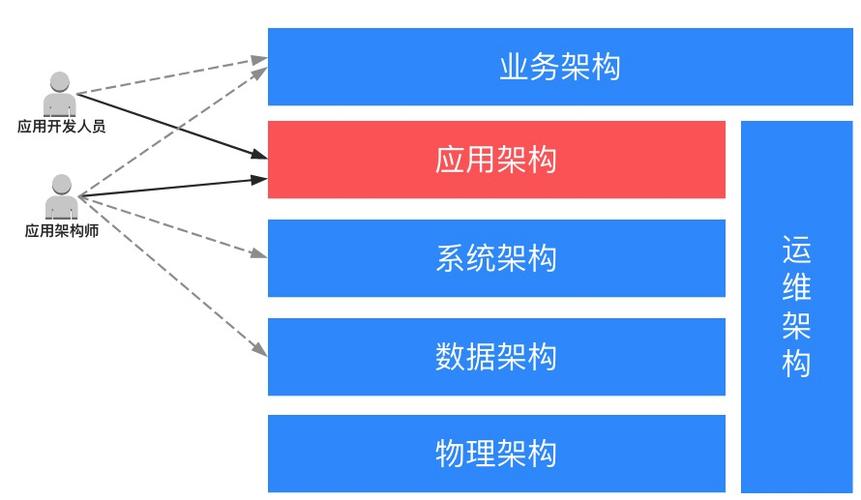

架构优化:从单体到分布式

微服务化拆分

传统的单体架构在高并发场景下难以扩展,建议采用微服务架构,将核心功能拆分为独立服务:

- 订单服务:处理下单、支付回调

- 库存服务:管理商品库存,防止超卖

- 用户服务:处理登录、权限校验

- 支付服务:对接第三方支付渠道

优势:

- 各服务可独立扩展,避免单点故障

- 降低数据库压力,提高系统整体吞吐量

引入消息队列(MQ)

在高并发场景下,直接写入数据库可能导致性能瓶颈,可以采用消息队列(如Kafka、RabbitMQ)进行异步处理:

- 订单异步化:用户下单后,先写入MQ,再由消费者处理,避免数据库瞬时压力过大。

- 削峰填谷:MQ可以缓冲流量,避免系统被突发流量击垮。

示例代码(RabbitMQ + Spring Boot):

@RabbitListener(queues = "order_queue")

public void processOrder(Order order) {

// 处理订单逻辑

orderService.process(order);

}

数据库优化:避免成为性能瓶颈

分库分表

当单表数据量超过500万时,查询性能会显著下降,可采用水平分表或垂直分库:

- 按用户ID分库:不同用户的数据存储在不同库中

- 按时间分表:如按月份拆分订单表

工具推荐:

- ShardingSphere(Apache开源分库分表中间件)

- MyCat(MySQL分库分表代理)

读写分离

- 主库:负责写入(INSERT/UPDATE/DELETE)

- 从库:负责查询(SELECT),减轻主库压力

实现方式:

- MySQL主从复制

- 使用中间件(如MyBatis + 动态数据源)

优化SQL查询

- 避免全表扫描:使用索引(如

WHERE user_id = ?) - 减少JOIN操作:改用缓存或冗余字段

- 批量操作:使用

INSERT INTO ... VALUES (), (), ()代替循环插入

缓存策略:减少数据库压力

Redis缓存热点数据

- 商品信息缓存:减少频繁查询数据库

- 库存预扣减:使用Redis原子操作(

INCRBY/DECRBY)防止超卖

示例(Redis + Lua脚本防超卖):

local stock = tonumber(redis.call('GET', KEYS[1]))

if stock >= tonumber(ARGV[1]) then

redis.call('DECRBY', KEYS[1], ARGV[1])

return 1 -- 扣减成功

else

return 0 -- 库存不足

end

多级缓存架构

- 本地缓存(Caffeine):减少Redis访问

- 分布式缓存(Redis):存储全局数据

- CDN缓存:静态资源加速

负载均衡与限流

Nginx负载均衡

upstream backend {

server 192.168.1.1:8080 weight=5;

server 192.168.1.2:8080 weight=3;

server 192.168.1.3:8080 backup; # 备用服务器

}

server {

listen 80;

location / {

proxy_pass http://backend;

}

}

限流策略

- 令牌桶算法(Guava RateLimiter)

- 漏桶算法(Nginx限流模块)

- 分布式限流(Redis + Lua)

示例(Spring Cloud Gateway限流):

spring:

cloud:

gateway:

routes:

- id: order-service

uri: lb://order-service

predicates:

- Path=/api/order/**

filters:

- name: RequestRateLimiter

args:

redis-rate-limiter.replenishRate: 100 # 每秒100个请求

redis-rate-limiter.burstCapacity: 200 # 突发流量200

实战案例:某发卡网双11大促优化

问题描述

某发卡网在双11期间遭遇:

- 峰值QPS 10万+,数据库CPU飙升至100%

- 部分用户下单失败,超卖现象严重

解决方案

- 引入Redis集群,缓存商品库存,使用Lua脚本保证原子性扣减。

- 订单服务异步化,通过Kafka削峰,降低数据库写入压力。

- Nginx + Keepalived 实现高可用负载均衡。

- 限流策略:针对恶意刷单IP进行动态封禁。

效果

- 数据库负载下降80%

- 订单处理速度提升5倍

- 0超卖事故

提升发卡网的高并发处理能力,需要从架构设计、数据库优化、缓存策略、负载均衡、代码优化等多个方面入手,本文提供的方案已在多个实际项目中验证有效,希望能帮助开发者构建更稳定、更高效的交易系统。

最后的小建议:

- 监控先行:使用Prometheus + Grafana实时监控系统状态

- 压测验证:通过JMeter模拟高并发场景,提前发现瓶颈

技术没有银弹,但合理的架构 + 持续的优化 = 稳定的系统! 🚀

本文链接:https://www.ncwmj.com/news/4468.html