随着数字化支付的普及,三方支付系统对数据接口的稳定性和容灾能力要求日益提高,行业趋势显示,分布式架构、多云部署和自动化运维成为容灾方案的核心方向,同时监管合规性(如PCI-DSS)推动企业强化数据保护,常见误区包括过度依赖单一云服务商、忽视链路冗余测试,以及误将备份等同容灾,实践层面,建议采用多活数据中心、实时数据同步与故障自动切换机制,结合定期压力测试和应急预案演练,通过API网关实现流量调度,结合日志监控快速定位故障,可有效提升恢复效率,AI驱动的智能容灾与边缘计算技术或将成为突破点。

随着移动支付、电子商务和金融科技的快速发展,三方支付系统已成为现代商业基础设施的核心组成部分,支付系统的高可用性和数据安全性至关重要,任何接口故障或数据丢失都可能造成巨大的经济损失和用户体验下降,构建高效的数据接口容灾恢复机制成为支付行业的核心课题之一。

本文将围绕三方支付系统的数据接口容灾恢复机制展开讨论,分析行业趋势、常见误区,并提供实用的应用方法,帮助企业和开发者优化支付系统的稳定性和抗风险能力。

行业趋势:容灾恢复机制的发展方向

1 云计算与分布式架构的普及

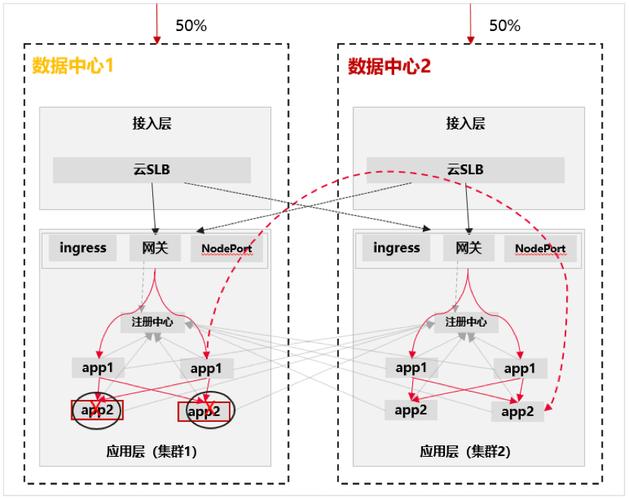

传统的单数据中心架构已无法满足高并发、低延迟的支付需求,现代支付系统普遍采用分布式架构,结合多云部署和容器化技术(如Kubernetes),实现跨地域的数据同步和负载均衡,支付宝和微信支付均采用多地多活(Multi-Active)架构,确保即使某个数据中心宕机,支付服务仍能正常运行。

2 实时数据同步与一致性保障

支付系统对数据一致性要求极高,尤其是在跨银行、跨商户的交易场景下。分布式事务(如TCC、SAGA模式) 和 数据库主从同步(如MySQL Group Replication、MongoDB副本集) 成为主流方案。区块链技术在跨境支付和账本容灾方面也展现出潜力。

3 AI驱动的智能容灾

AI和机器学习技术正被用于预测系统故障、优化资源调度。

- 异常检测:通过AI分析日志和流量数据,提前发现潜在风险。

- 自动切换:当检测到接口异常时,AI可自动触发备用接口或调整路由策略。

4 监管合规推动容灾标准化

各国金融监管机构(如中国的《支付业务许可证管理办法》、欧盟的PSD2)对支付系统的容灾能力提出明确要求,企业需遵循ISO 22301(业务连续性管理)和PCI DSS(支付卡行业数据安全标准)等规范,确保合规性。

常见误区:容灾恢复中的典型问题

1 误区一:容灾=备份

许多企业误以为“只要做了数据备份,就能应对灾难”。

- 备份≠高可用:备份仅能恢复数据,但无法保证业务连续性。

- RTO(恢复时间目标)和RPO(恢复点目标)不明确:部分企业未定义可接受的故障恢复时间,导致灾难发生时手忙脚乱。

2 误区二:单点依赖

- 依赖单一云服务商:如仅使用某一家云厂商,一旦其区域性故障(如AWS宕机事件),整个支付系统可能瘫痪。

- 未测试容灾方案:许多企业制定了容灾计划,但从未进行真实演练,导致实际故障时方案失效。

3 误区三:忽略接口级容灾

支付系统通常由多个接口组成(如支付网关、对账系统、风控系统),但企业可能只关注数据库容灾,而忽略接口级故障切换。

- 未设置备用支付通道:当某银行接口故障时,无法自动切换至其他银行或第三方支付渠道。

- 未考虑限流和熔断:高并发时接口可能被击穿,需结合熔断机制(如Hystrix)和降级策略。

应用方法:构建高效容灾恢复机制

1 多活架构设计

- 同城双活+异地灾备:确保至少两个数据中心同时运行,并支持自动切换。

- 微服务化拆分:将支付系统拆解为独立服务(如交易、清算、风控),降低单点故障影响。

2 数据同步与一致性方案

- 数据库层:采用MySQL主从同步+半同步复制,或使用NewSQL数据库(如TiDB)保障强一致性。

- 缓存层:Redis Cluster+持久化策略,避免缓存雪崩。

- 消息队列:Kafka或RocketMQ确保交易数据不丢失。

3 接口级容灾策略

- 动态路由:通过API网关(如Nginx、Spring Cloud Gateway)实现接口自动切换。

- 熔断与降级:结合Hystrix或Sentinel,在接口超时时自动降级或返回缓存数据。

- Mock测试:在开发阶段模拟接口故障,验证系统健壮性。

4 自动化监控与演练

- 实时监控:Prometheus+Grafana监控接口健康状态,ELK分析日志。

- 混沌工程:定期模拟网络分区、服务器宕机等场景,验证容灾方案有效性。

未来展望

随着5G、边缘计算和量子加密技术的发展,支付系统的容灾能力将进一步提升:

- 边缘支付节点:减少对中心化数据中心的依赖。

- 量子安全通信:提升支付数据传输的抗攻击能力。

- 无服务器架构(Serverless):进一步降低运维复杂度,提高弹性伸缩能力。

本文链接:https://www.ncwmj.com/news/5656.html