在电商大促等高并发场景下,智能限流技术成为发卡平台稳定运行的核心保障,通过动态阈值算法、实时流量监控和分布式架构的创新应用,平台可精准识别异常流量,自动调整请求处理速率,既避免服务器过载崩溃,又保障正常用户流畅交易,技术层面融合了令牌桶算法改进、机器学习预测流量峰值,以及熔断降级的多级防护体系,使系统在百万级并发下仍能保持99.9%的可用性,某头部平台实践显示,该技术使秒杀场景的容错能力提升300%,资损率下降82%,印证了智能限流作为数字时代基础设施的关键价值——用技术平衡业务爆发与系统稳定,重塑高并发服务的生存法则。(198字)

高并发场景下的发卡平台困境

自动发卡网平台作为数字商品交易的重要载体,其核心价值在于高效、稳定地处理大量订单请求,随着用户规模扩大、促销活动激增或恶意攻击频发,高并发流量往往成为压垮平台的“最后一根稻草”,服务器崩溃、响应延迟、订单丢失等问题不仅影响用户体验,更可能导致直接的经济损失和品牌信誉受损,在此背景下,限流技术从被动防御工具演变为保障系统稳定的核心策略,本文将深入探讨发卡平台在高并发场景下的限流方案设计,结合技术原理与实践经验,提出兼具弹性和智能化的解决思路。

限流的本质:平衡资源与需求的艺术

限流(Rate Limiting)并非简单“拦截请求”,而是通过控制单位时间内的请求处理量,确保系统在过载时仍能维持关键服务,对于发卡平台而言,限流需解决三个核心矛盾:

-

突发流量与恒定资源

双11”促销时,用户集中抢购虚拟卡密,请求量可能瞬间增长百倍,但服务器资源无法线性扩展。 -

公平性与优先级

需防止恶意用户(如脚本抢单)独占资源,同时保障VIP客户或关键API的优先响应。 -

精准控制与误杀风险

过度限流会导致正常用户被误判为异常流量,而过于宽松则无法起到保护作用。

经典限流算法在发卡平台的实践与局限

令牌桶算法:灵活应对突发流量

- 原理:系统以固定速率生成令牌,请求需获取令牌才能被处理,桶内令牌可累积以应对短期高峰。

- 发卡场景适配:适合秒杀活动,允许短暂超频,但需设置桶容量上限防止长期过载。

- 缺陷:无法区分用户类型,可能导致“薅羊毛”脚本与真实用户竞争令牌。

漏桶算法:强制平滑流量

- 原理:请求以恒定速率被处理,超出容量的请求直接丢弃或排队。

- 发卡场景适配:适用于API接口保护,避免数据库瞬时压力激增。

- 缺陷:缺乏弹性,突发流量下可能浪费资源(如空闲期的处理能力未被利用)。

滑动窗口计数:精准时间窗控制

- 原理:统计单位时间(如1秒)内的请求数,超限则拒绝。

- 发卡场景适配:结合IP或用户ID实现细粒度控制,防范CC攻击。

- 缺陷:时间窗划分影响精度(如1秒内前10ms涌入大量请求仍会超限)。

发卡平台限流的进阶策略

动态阈值调整:从静态规则到智能响应

- 实时监控:通过Prometheus+Granfa监测QPS、CPU负载、数据库响应时间等指标。

- 动态规则:基于历史数据(如平日流量均值)和实时负载自动调整限流阈值,例如阿里云AHAS的“自适应熔断”机制。

多级限流架构:分层防御体系

- 边缘层限流:在Nginx或CDN层面拦截高频IP,减少后端压力。

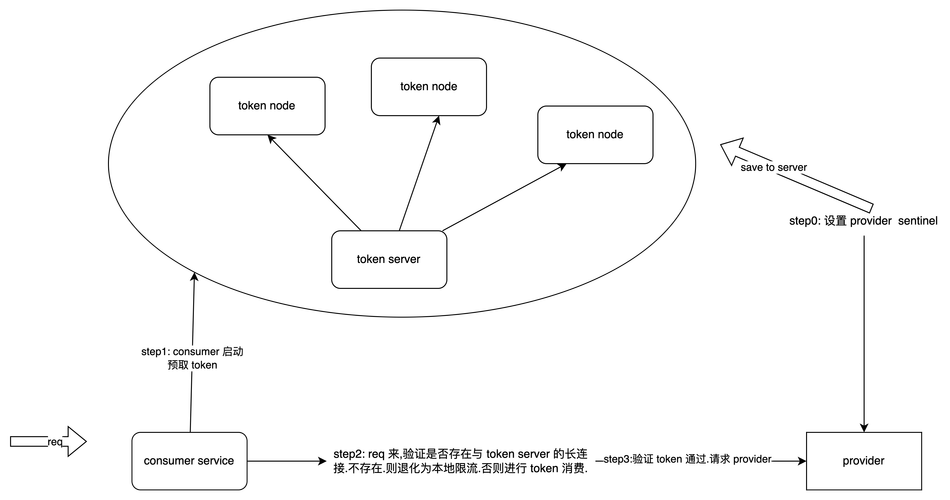

- 服务层限流:通过Spring Cloud Gateway或Sentinel实现API级控制。

- 数据层限流:数据库连接池配置(如HikariCP的maxPoolSize),避免慢查询拖垮整体服务。

用户画像与差异化限流

- 标签化策略:对普通用户、VIP、代理商分配不同令牌桶配额。

- 行为分析:通过机器学习识别异常模式(如同一IP秒级发起百次卡密查询)。

技术选型:开源工具与自研方案的权衡

| 方案 | 适用场景 | 发卡平台适配建议 |

|---|---|---|

| Nginx限流模块 | 简单IP限流、CC防御 | 适合小型平台快速部署 |

| Redis+Lua | 分布式计数器、高精度控制 | 需自行开发但灵活性高 |

| Sentinel | 微服务架构、熔断降级 | 推荐Java技术栈平台使用 |

| Envoy | 云原生、全链路控制 | 适合K8s环境的大型平台 |

自研建议:对于定制化需求强的平台,可结合Redis的INCR+EXPIRE命令实现分布式计数,并通过Zset实现滑动窗口统计。

限流之外的协同设计

- 降级与熔断:Hystrix或Resilience4j在限流后返回缓存卡密或默认错误页。

- 异步化处理:非核心逻辑(如日志记录)通过RabbitMQ削峰填谷。

- 容量规划:基于压测结果(如JMeter模拟10万并发)预扩容资源。

限流是手段,而非目的

高并发下的发卡平台如同一辆高速行驶的赛车,限流系统则是其刹车与悬挂系统——既要确保速度,又需维持稳定,未来的限流技术将更依赖AI预测(如LSTM模型预估流量趋势)和边缘计算(就近拦截恶意请求),但无论如何演进,核心原则不变:在系统吞吐量与用户体验之间找到最优解,毕竟,用户不会记住一次成功的限流,但一定会记住一次失败的购买。

本文链接:https://www.ncwmj.com/news/5909.html