在高并发场景下,发卡网交易系统需通过多维度技术优化保持稳定性和响应速度,核心策略包括:采用分布式架构实现水平扩展,通过负载均衡分散流量压力;利用Redis等内存数据库缓存热点数据,减少数据库IO瓶颈;引入消息队列(如Kafka)异步处理订单,削峰填谷;结合数据库分库分表与连接池优化,提升事务处理能力;实施限流熔断机制(如Sentinel)防止系统过载,通过无状态设计、CDN加速静态资源及代码级并发控制(如锁优化、线程池调优),确保系统在高负载下仍能维持低延迟、高可用的"优雅"状态,同时需配合全链路压测与实时监控体系持续迭代。

在数字化支付日益普及的今天,发卡网交易系统作为虚拟商品交易的重要基础设施,其稳定性和性能直接影响用户体验和平台收益,随着用户规模扩大,多用户并发请求的挑战愈发严峻,如何在高并发场景下确保系统稳定、响应迅速、数据一致?这不仅是一个技术问题,更是一场对系统架构、数据库优化、缓存策略和业务逻辑的全面考验。

并发请求的本质:流量洪峰下的系统韧性

并发请求并非简单的“同时访问”,而是指在同一时间窗口内,系统需要处理大量相互独立或相互依赖的操作,对于发卡网交易系统而言,典型的并发场景包括:

- 秒杀抢购:热门虚拟商品(如游戏点卡、会员激活码)在短时间内被大量用户争抢。

- 支付回调风暴:第三方支付平台在交易高峰期集中回调,导致系统短时间内处理大量异步通知。

- 库存超卖风险:多个用户同时下单同一商品,若库存管理不当,可能导致超卖或数据不一致。

这些场景下,系统的表现直接决定了用户体验和平台信誉,一个崩溃的发卡网系统,不仅会让用户流失,还可能引发投诉甚至法律风险。

并发测试的四大核心指标

要确保系统在高并发下稳定运行,必须进行严格的压力测试,重点关注以下指标:

- TPS(每秒事务数):系统在单位时间内能成功处理多少笔交易。

- 响应时间:从用户发起请求到收到结果的平均耗时,超过500ms就可能影响体验。

- 错误率:请求失败的比例,理想情况下应低于0.1%。

- 资源占用率:CPU、内存、磁盘I/O、网络带宽的消耗情况,避免因资源耗尽导致雪崩。

实战优化:从架构到代码的并发策略

分布式架构:化整为零,分而治之

单机架构在面对高并发时往往捉襟见肘,因此现代发卡网系统通常采用微服务或分布式架构:

- 服务拆分:将交易、库存、支付、日志等模块解耦,避免单点故障。

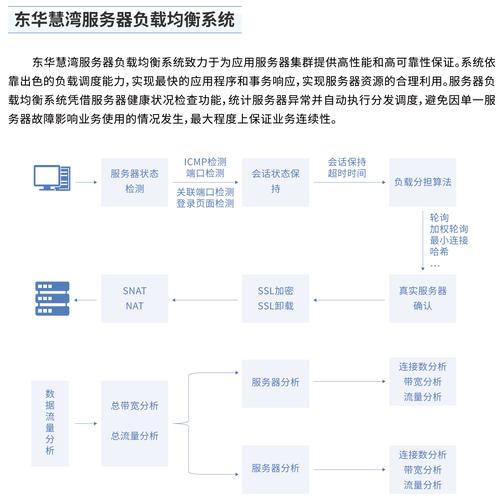

- 负载均衡:通过Nginx、Kubernetes等工具将流量均匀分配到多台服务器。

- 数据库分库分表:避免单一数据库成为瓶颈,例如按用户ID哈希分片。

缓存:用空间换时间

- Redis缓存热点数据:如商品库存、用户余额,减少数据库查询压力。

- 多级缓存策略:本地缓存(如Caffeine)+ 分布式缓存(如Redis)结合,提升命中率。

- 缓存击穿防护:使用互斥锁(Mutex Lock)或布隆过滤器(Bloom Filter)避免恶意请求穿透缓存。

异步化与消息队列

- 削峰填谷:使用RabbitMQ、Kafka等消息队列缓冲瞬时高峰请求,避免系统过载。

- 最终一致性:对于非核心流程(如日志记录、通知推送),可采用异步处理,确保主链路高效。

数据库优化:锁的艺术

- 乐观锁 vs. 悲观锁:

- 乐观锁(如CAS)适合读多写少场景,通过版本号控制并发修改。

- 悲观锁(如SELECT FOR UPDATE)适合强一致性需求,但可能降低吞吐量。

- 避免长事务:尽量缩短数据库事务持有时间,减少锁竞争。

限流与熔断

- 令牌桶算法:控制每秒允许的请求数,超出部分直接拒绝或降级。

- 熔断机制:当系统负载过高时,自动关闭非核心功能(如查询历史订单),优先保障交易核心链路。

真实案例:一次并发测试的教训

某发卡网平台在促销活动中遭遇了严重的并发问题:用户抢购时系统崩溃,库存出现超卖,事后分析发现:

- 数据库未做分库分表,导致单表QPS超过5000后响应急剧下降。

- 缓存策略不当,库存数据未预热,大量请求直接击穿到数据库。

- 未设置限流,突发流量直接打满服务器CPU。

通过引入Redis集群、优化SQL索引、增加限流策略,该平台在后续测试中成功支撑了每秒1万+的并发请求。

未来展望:Serverless与AI驱动的弹性伸缩

随着云原生技术的发展,未来的发卡网系统可能会更依赖:

- Serverless架构:按需分配资源,避免闲置成本。

- AI预测流量:通过机器学习分析历史数据,提前扩容以应对高峰。

并发不是洪水猛兽,而是技术进化的催化剂

高并发测试并非只是为了“扛住流量”,而是通过模拟极端场景,暴露系统的脆弱点,进而优化架构和代码,发卡网交易系统的并发能力,本质上反映了技术团队对业务的理解深度和工程能力,只有持续迭代、不断压测,才能在真实的流量洪峰中保持优雅。

本文链接:https://www.ncwmj.com/news/6132.html