,分布式交易系统的订单调度高可用设计,是一场围绕“冗余”与“容错”的攻防实战,其核心防御策略是采用主从集群模式,通过ZooKeeper或Etcd等组件实现主节点的选举与状态监控,确保主节点故障时能自动、迅速地将流量切换至热备从节点,实现故障转移(Failover),在攻击层面,需防范因网络分区引发的“脑裂”问题,通过严格的Quorum机制和心跳检测避免双主产生,系统必须具备优雅降级能力,在极端情况下通过熔断、限流等手段保住核心订单流程,并设计对账与补偿机制以应对状态不一致,最终构建一个能自动故障恢复、业务无损的高可用服务体系。

2023年5月,某头部券商交易系统突发故障,两小时内无法正常交易,最终被证监会出具警示函,事件背后,正是订单调度系统的高可用设计存在缺陷,在当今每秒处理数百万笔订单的金融市场上,如何确保分布式订单调度系统始终稳定运行,已成为金融科技领域的核心挑战。

为什么订单调度系统如此脆弱?

订单调度系统本质上是一个金融交易的中枢神经系统,它接收来自各类终端(手机APP、PC客户端、API接口)的交易请求,经过风控检查、资金校验后,将订单路由到不同的交易所或流动性提供商,这个过程中存在多个单点故障风险:网络抖动可能导致心跳检测失败,硬件故障可能使整个节点瘫痪,软件缺陷可能引发雪崩式崩溃,甚至人为误操作都可能导致服务中断。

更深层次的问题在于,金融交易对一致性和延迟有着近乎苛刻的要求,分布式系统著名的CAP理论告诉我们,在网络分区的情况下,必须在一致性和可用性之间做出选择,而交易系统往往选择优先保证一致性——因为错误交易比无法交易后果更严重,这种选择使得高可用设计面临更大挑战。

核心架构:如何构建故障自愈的调度系统?

现代分布式订单调度系统的高可用设计建立在多层防御体系上:

无状态设计优先:将调度节点设计为无状态服务,任何请求都可以被任意节点处理,通过将会话信息外部化到分布式缓存(如Redis集群),即使单个节点故障,用户请求也能被其他节点无缝接管,这是实现水平扩展和快速故障转移的基础。

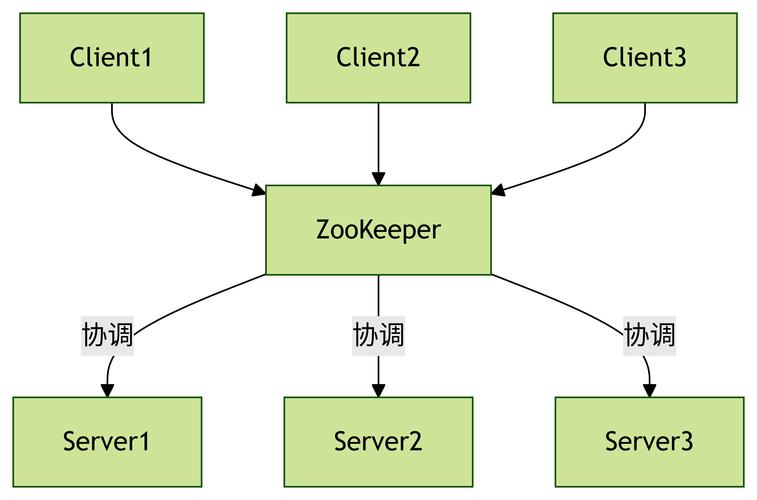

智能路由与负载均衡:采用基于ZooKeeper/Etcd的服务注册与发现机制,实时监控节点健康状态,不仅实现传统的轮询或随机负载均衡,更开发了基于实时负载的智能路由——考虑节点的CPU、内存、网络延迟和订单处理量,将新请求导向最空闲的节点。

分级熔断与降级:借鉴“弹性设计”理念,实现精细化的熔断机制,当某个交易所接口响应缓慢时,自动熔断并向其他路由切换;当系统整体负载过高时,启动降级策略(如暂停复杂订单类型)保障核心功能,如同电力系统中的分级断电,优先保证最重要功能。

数据一致性:不可妥协的设计难题

在分布式环境中,最大的技术挑战之一是如何保证订单数据的一致性,采用两阶段提交(2PC)协议虽然能保证强一致性,但会严重降低系统可用性——当协调者故障时,所有参与者都将阻塞。

更先进的方案是使用最终一致性模型配合幂等设计:

- 通过唯一订单ID保证重复请求不会导致多次交易

- 采用事件溯源模式,将状态变化记录为不可变事件序列

- 使用分布式事务方案如TCC(Try-Confirm-Cancel)或Saga模式

实际应用中,往往采用分层一致性策略:对资金扣减等核心操作保持强一致性,对非关键操作(如交易记录同步)采用最终一致性。

网络分区下的生存策略

网络分区是分布式系统的“终极测试”,当节点间失去连接时,系统必须能够做出正确决策:

脑裂防护机制:通过Quorum算法(多数决)避免双主问题,要求调度节点必须获得超过半数的仲裁节点认可才能继续服务,否则自动降级为只读模式。

自动收敛与恢复:网络恢复后,系统需要自动解决数据冲突,基于时间戳或版本向量的冲突解决算法可以自动合并不同分区的数据变更,最大限度减少人工干预。

实战中的容灾演练与混沌工程

高可用设计不能仅停留在理论层面,领先的金融科技公司定期进行“故障注入”测试:

- 随机终止生产环境中的容器节点

- 模拟网络延迟和数据包丢失

- 故意制造资源耗尽场景

- 进行全机房断电演练

通过这种“混沌工程”实践,不断验证和完善系统的容错能力,正如消防演练一样,只有在平时模拟各种灾难场景,才能在真实故障中从容应对。

未来挑战与演进方向

随着量子计算、区块链等新技术的发展,订单调度系统面临新的机遇与挑战:

- 量子安全加密算法需要集成到现有系统中

- 区块链技术可能提供新型分布式共识方案

- AI预测性扩缩容能够提前预判流量高峰

- 边缘计算使得订单调度更靠近交易所,降低延迟

分布式订单调度系统的高可用设计是一场永无止境的攻防战,在这个没有终点的旅程中,唯有保持敬畏之心,坚持防御性设计,深入理解故障模式,才能构建出真正可靠的金融基础设施,毕竟,在金融市场中,每一秒的系统故障都可能意味着数千万的损失——这是技术人承担的最重责任之一。

本文链接:https://www.ncwmj.com/news/6925.html