在网络世界中,发卡网作为虚拟商品的交易枢纽,其核心资产“数字货架”时刻面临着自动化爬虫程序的冲击,这些爬虫不仅肆意抓取商品信息、价格等敏感数据,导致平台运营失衡与经济损失,更可能引发库存欺诈与恶意下单等复杂问题,为守护这片数字阵地,发卡网展开了一场技术攻防战:它们部署验证码系统以拦截初级脚本,运用动态变化的网页代码增加数据抓取难度,并通过实时监控与分析流量,精准识别并封禁高频恶意IP地址,这是一场在虚拟前线持续进行的智慧博弈,平台必须不断升级防御策略,才能在爬虫大军的侵扰中确保交易的稳定与公平。

不只是你买我卖那么简单

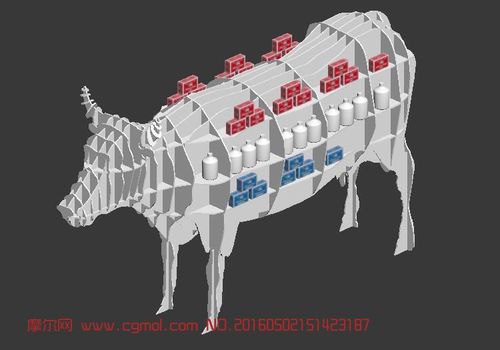

想象一下,你经营着一家线上超市,货架上摆满了琳琅满目的商品——只不过这些商品是一串串的数字卡密(充值卡、游戏点卡、会员激活码等),这就是“发卡网”的日常,与实体店不同,这家超市一天24小时都面临着看不见的“顾客”——网络爬虫,它们不知疲倦地扫描、抓取、复制你所有的商品信息和价格,要么为竞争对手提供情报,要么直接将你的卡密盗走转卖。

这不仅是经济损失,更是对平台信誉和用户信任的致命打击,发卡网的开发者们是如何构建防线,与这些“爬虫大军”斗智斗勇的呢?我们就从多个角度深入这场没有硝烟的技术攻防战。

第一防线:前端交互的“迷惑术”与“验证关”

爬虫最初的目标是简单直接的:模拟浏览器,访问网页,然后提取结构化的数据,第一道防线就在这里展开,核心思想是 “让机器看不懂,进不来”。

-

动态渲染与数据混淆

- 传统痛点:早期的发卡网,卡密信息可能直接写在网页的HTML源代码里,爬虫不费吹灰之力就能拿到,这就像把保险箱密码贴在箱子上。

- 现代方案:现在普遍采用前后端分离架构,前端(用户看到的页面)只是一个空壳,真正的卡密数据通过后端API接口在用户执行特定操作(如点击“查看卡密”按钮)后,才动态加载。

- 技术实现:使用JavaScript(尤其是Vue、React等框架)异步请求数据,爬虫直接抓取HTML只能得到一堆无用的标签,而看不到核心卡密,更进一步,可以对API返回的JSON数据进行混淆加密,比如将字符串进行Base64编码、字符顺序颠倒或自定义加密算法,前端再通过对应的JavaScript逻辑进行解密显示,这大大增加了爬虫直接解析数据的难度。

-

强大的验证码系统

- 基础防御:图形验证码(扭曲的文字、数字)是最常见的门槛,用于区分人和机器。

- 进阶防御:Google reCAPTCHA等智能验证码已经进化到“无感验证”,它通过分析用户的行为特征,如鼠标移动轨迹、点击模式、在页面的停留时间等,来判断访问者是真人还是机器人,用户可能只需勾选一个“我不是机器人”的复选框,甚至什么都不用做就能通过验证,但对于爬虫程序来说,模拟人类复杂的行为模式极其困难。

-

人机交互验证

除了验证码,还可以引入简单的行为挑战,必须将拼图滑块拖到正确位置,或按特定顺序点击一组图片中的元素,这些操作对于人类来说轻而易举,但对于程序化的爬虫则构成了显著的障碍。

第二防线:后端逻辑的“规则墙”与“身份锁”

如果爬虫绕过了前端,开始直接模拟API请求,战斗就进入了后端领域,这里的核心是 “识别异常,阻断攻击”。

-

频率限制与IP封禁

- 基础规则:这是最直接有效的措施,系统会监控单个IP地址在单位时间内的请求频率,一个正常用户不会在一秒钟内请求查看100次卡密,一旦触发阈值,系统会立即对该IP进行临时封禁或要求进行验证码验证。

- 对抗升级:高级爬虫会使用IP代理池,不断切换IP地址,为此,防御方需要建立更智能的风控系统,通过分析IP信誉库(标记已知的代理IP、数据中心IP)、用户代理(UA)字符串的异常等,来识别和封禁可疑的流量。

-

请求签名与参数校验

- 原理:防止爬虫直接伪造API请求,关键API(如“获取卡密”)的请求必须携带一个由前端生成的、有时效性的“签名”,这个签名通常由请求参数、时间戳和一个只有前后端知道的密钥通过特定算法(如HMAC-SHA256)生成。

- 效果:爬虫即使抓取到了请求的URL,也无法伪造正确的签名,因为缺少密钥,服务器在收到请求后会重新计算签名进行比对,不一致则立即拒绝,这就像给你的每个请求都盖了一个无法伪造的电子公章。

-

用户会话与登录态校验

- 强制登录:要求用户必须登录账户后才能查看卡密,这不仅是为了关联订单,更是增加爬虫的作业成本,爬虫需要先搞定注册和登录流程,才能进行下一步。

- 会话管理:服务器通过Cookie或Token来维持用户的登录状态,系统可以监控会话的异常行为,例如一个会话在短时间内从多个地理位置不同的IP登录,这显然是异常信号。

第三防线:架构与业务的“纵深战”

最坚固的堡垒往往拥有多层次的防御体系,在架构和业务层面,可以部署更具战略性的防护。

-

Web应用防火墙

- 企业级盾牌:WAF是部署在网站之前的专业安全产品,它内置了庞大的恶意流量特征库,可以实时识别和阻断包括爬虫在内的各种网络攻击,如SQL注入、跨站脚本(XSS)等,云服务商(如阿里云、腾讯云)都提供成熟的WAF服务,能为发卡网提供强有力的保护。

-

业务逻辑隔离与延迟暴露

- 核心策略:不一次性给出所有信息,在用户支付成功后,不立即显示全部卡密,而是先显示部分打码的信息(如

卡号:138*****890),用户需要再次点击“确认查看”才能获取完整卡密,这增加了爬虫的抓取步骤和复杂度。 - 时间锁:甚至可以设置支付成功后几分钟才能查看卡密,打乱自动化脚本的节奏。

- 核心策略:不一次性给出所有信息,在用户支付成功后,不立即显示全部卡密,而是先显示部分打码的信息(如

-

蜜罐技术

- 诱敌深入:在网页的HTML代码中,故意插入一些对用户不可见(如通过CSS隐藏)、但对爬虫可见的“假卡密”链接或数据,一旦有IP访问了这些蜜罐资源,系统就可以立即将其标记为恶意爬虫并进行封禁,这是一种非常主动且高效的防御手段。

一场永无止境的“猫鼠游戏”

发卡网的防爬取,从来不是依靠单一技术就能一劳永逸的,它是一场持续的、动态的攻防博弈。

- 对爬虫方而言:他们在不断进化,使用更逼真的浏览器模拟工具(如Selenium、Puppeteer),结合机器学习来识别验证码,甚至雇佣“人工打码”平台来绕过验证。

- 对防御方而言:需要构建一个纵深防御体系,从前端混淆到后端频控,从验证码到WAF,再到业务逻辑的巧妙设计,层层设卡,步步为营。

未来的趋势将是更加智能化,通过大数据和AI技术,分析用户的行为序列,建立每个用户的正常行为基线,任何偏离基线的操作——无论是速度、节奏还是路径——都会触发风控警报,届时,防御系统将不再仅仅是执行死板的规则,而是像一个经验丰富的保安,能够“感觉”出谁是来买东西的真人,谁是别有用心的机器。

对于发卡网经营者来说,投资健壮的安全防护,不仅仅是保护眼前的利润,更是守护平台的长期生命线和用户在数字世界中对你的那份宝贵信任。

本文链接:https://www.ncwmj.com/news/7769.html