发卡网业务面临瞬时高并发支付与卡密发放挑战,初期架构在活动期常因流量突增而“秒崩”,通过系统性的架构演进,最终实现了稳定支撑“秒杀”级高并发的目标。,核心演进路径包括:**前端**采用静态资源CDN加速、请求排队与按钮防重复点击;**接入层**通过负载均衡集群分流,并设置恶意请求过滤;**核心服务**进行无状态化改造,利用Redis集群进行缓存预热、库存扣减与分布式锁控制,数据库通过分库分表与读写分离提升处理能力;**订单与发放**环节引入消息队列异步化解耦,确保卡密生成与发放的最终一致性,全链路监控与弹性伸缩机制保障了系统的持续稳定与高可用。,这一演进过程体现了从单体应用到分布式、从同步到异步、从数据库中心化到缓存与队列并重的核心架构思想,成功将系统从脆弱转为强韧。

当数字商品遇上抢购狂潮

想象一下这个场景:某热门游戏突然发布限量虚拟道具,数万玩家同时涌向发卡平台;或是某个软件开发商推出限时优惠激活码,技术爱好者们争分夺秒地下单——这就是发卡网日常可能面临的高并发考验,一次成功的促销可能因系统崩溃变成公关灾难,而一个稳健的架构则能让平台在流量洪峰中屹立不倒。

发卡网高并发挑战的特殊性

1 数字商品的独有特征

与实物电商不同,发卡网交易具有几个关键特点:

- 库存无上限但密钥唯一:数字商品可无限复制,但每个激活码、卡密必须全局唯一

- 即时交付要求:用户支付后期望“秒级”获得卡密,延迟将直接导致投诉

- 防欺诈压力大:虚拟商品更易成为黑产目标,风控需在毫秒级完成

2 典型并发场景

- 定时抢购:整点限量发售引发的瞬时流量

- 网红推广:KOL带货带来的突发性流量激增

- 节假日促销:规律性但难以精确预测的流量高峰

分层防御:从前端到数据库的全链路优化

1 前端层的“流量整形”

# 前端限流策略示例

1. 按钮防重复点击:提交后禁用按钮并显示倒计时

2. 排队机制:热门商品进入虚拟排队队列

3. 静态化处理:商品详情页静态化,减少后端请求

4. 地域分流:根据用户IP智能分配CDN节点2 网关层的“交通管制”

API网关作为第一道防线,承担着关键职责:

- 限流熔断:对单个IP/用户实施令牌桶限流

- 请求过滤:拦截明显异常请求(如每秒百次下单)

- 缓存响应:将热门商品信息缓存至网关层

3 业务层的“异步化改造”

核心思路:将同步操作拆解为异步流水线

# 传统同步流程(易阻塞)

用户请求 → 验证 → 扣库存 → 生成卡密 → 记录日志 → 返回结果

# 异步改造后

用户请求 → 验证 → 写入消息队列 → 立即返回“处理中”

↓

后台消费者异步处理:

1. 数据库扣减库存

2. 从卡密池分配唯一密钥

3. 更新订单状态

4. 发送站内信/邮件通知

4 数据层的“分而治之”

数据库优化策略:

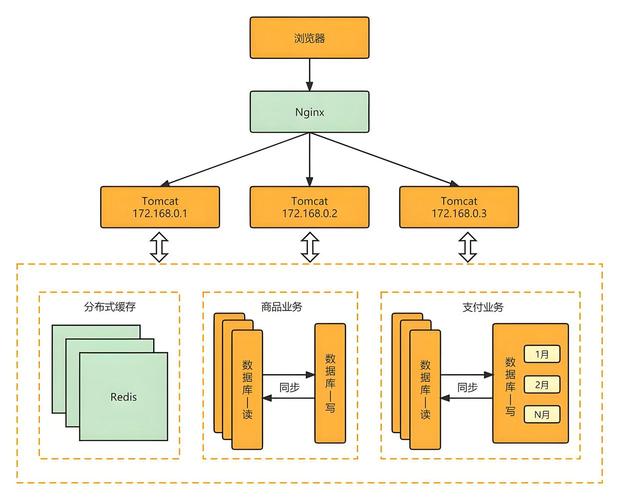

- 读写分离:主库处理写操作,多个从库分担读压力

- 分库分表:按商品类型、时间维度水平拆分

- 热点数据分离:将抢购商品库存单独存放于Redis集群

Redis多级缓存架构:

L1:本地缓存(Guava/Caffeine)→ 极热数据,纳秒级响应

L2:分布式Redis集群 → 热数据,毫秒级响应

L3:数据库 → 全量数据,最终一致性核心技术方案深度解析

1 库存管理的艺术

问题:超卖是发卡网最致命的故障

解决方案:

-- 悲观锁方案(简单但性能差)

BEGIN TRANSACTION;

SELECT stock FROM products WHERE id = ? FOR UPDATE;

UPDATE products SET stock = stock - 1 WHERE id = ? AND stock > 0;

COMMIT;

-- Redis+Lua原子操作方案(推荐)

local stock = redis.call('GET', KEYS[1])

if stock and tonumber(stock) > 0 then

redis.call('DECR', KEYS[1])

return 1 -- 扣减成功

else

return 0 -- 库存不足

end

2 唯一卡密生成与分配

挑战:高并发下如何快速生成唯一卡密且不重复

分布式解决方案:

- 预生成池:提前批量生成卡密存入Redis Set

- 分段获取:每个服务节点获取一批卡密ID范围

- 雪花算法:生成全局唯一ID作为卡密索引

3 支付回调的幂等性设计

// 支付回调接口的幂等实现

public String payCallback(String orderNo, String transactionId) {

// 1. 通过唯一索引防止重复订单

// 2. 使用分布式锁确保同一订单串行处理

// 3. 先更新订单状态再发货

// 4. 记录操作日志便于对账

}

实战中的特殊场景应对

1 秒杀场景的“漏斗模型”

入口层:100万请求 → 排队层:10万请求 →

业务层:1万请求 → 数据库:1000实际成交具体措施:

- 资格验证前置:在排队前完成用户身份验证

- 随机丢弃策略:在队列满时随机拒绝部分请求

- 逐步放行:按批次处理队列中的请求

2 突发流量应急预案

- 自动弹性伸缩:基于CPU/负载指标自动扩容

- 降级方案:非核心功能可降级(如关闭推荐算法)

- 静态兜底页:极端情况下返回静态维护页面

监控与持续优化体系

1 可观测性建设

- 链路追踪:全链路跟踪请求耗时

- 实时仪表盘:QPS、成功率、库存变化可视化

- 预警机制:设置阈值自动告警

2 压力测试常态化

# 测试策略

日常压测:模拟正常流量的2-3倍

月度大促演练:全链路压测,模拟极端场景

混沌工程:随机注入故障,测试系统韧性云原生与智能化

1 云原生架构演进

- 容器化部署:快速弹性伸缩

- 服务网格:细粒度流量管理

- Serverless:按需使用计算资源

2 AI在并发管理中的应用

- 智能预测:基于历史数据预测流量峰值

- 动态限流:根据实时负载调整限流阈值

- 异常检测:自动识别并拦截恶意流量模式

高并发不是技术炫技,而是商业基石

发卡网的高并发架构建设,本质上是在用户体验、系统成本和稳定性之间寻找最佳平衡点,没有一劳永逸的“银弹”,只有持续迭代的优化过程,从简单的缓存应用到复杂的分布式架构,每一次演进都是为了同一个目标:让用户在购买数字商品时,感受不到技术复杂性的存在,只享受流畅便捷的体验。

真正的优秀架构,不是能承受多高的峰值,而是在流量如潮水般涌来和退去时,都能保持优雅与从容,在这个数字商品交易日益频繁的时代,高并发能力已不再是技术选项,而是发卡平台的生存必需品。

本文仅提供技术思路参考,具体实施需根据业务场景、团队能力和资源状况综合决策,在高并发架构的道路上,没有最好的方案,只有最适合的方案。

本文链接:https://www.ncwmj.com/news/9135.html